之前搭建glm4结果显卡带不动,只好退而求其次

环境准备: python3.12,miniconda,安装时都要加入path,即环境变量

先把项目给git下来,无论是git还是下载zip解压都可以

git clone https://github.com/THUDM/ChatGLM3.git

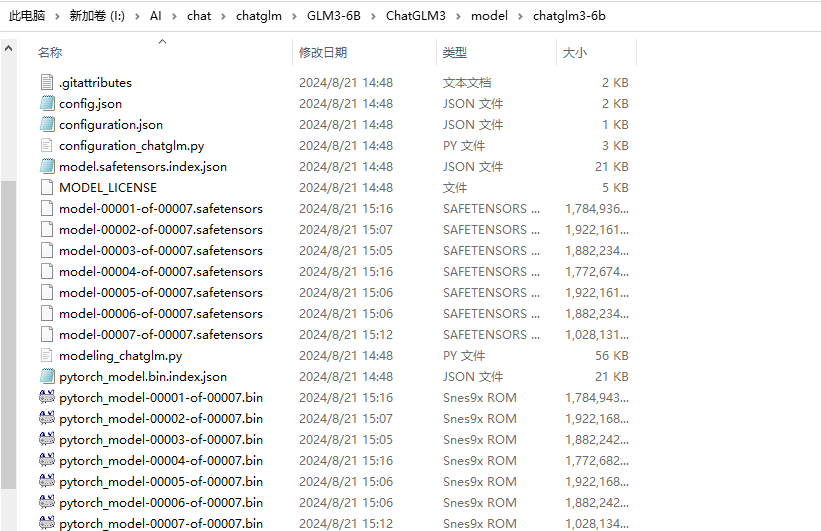

然后创建一个model目录,把需要的模型也给git下来

git lfs install

git clone https://www.modelscope.cn/ZhipuAI/chatglm3-6b.git

安装依赖

把requirements.txt 的#vllm>=0.4.2注释掉

PS I:\AI\chat\chatglm\GLM3-6B\ChatGLM3> pip install -r requirements.txt

进入I:\AI\chat\chatglm\GLM3-6B\ChatGLM3\composite_demo

创建conda环境,安装依赖

conda create -n glm-4-demo python=3.12

conda activate glm-4-demo

pip install -r requirements.txt -i https://mirror.sjtu.edu.cn/pypi/web/simple

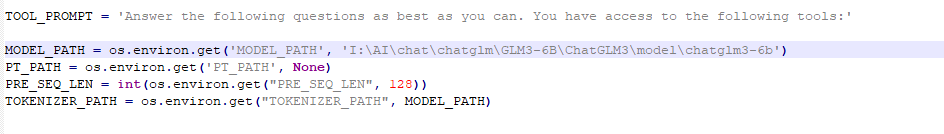

修改model path为刚刚下载模型的路径

如果是venv环境需要单独安装

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu124

启动

streamlit run main.py

附录:

项目地址

https://github.com/THUDM/ChatGLM3

模型下载地址

| Model | Seq Length | Download |

|---|---|---|

| ChatGLM3-6B | 8k | HuggingFace | ModelScope | WiseModel | OpenXLab |

| ChatGLM3-6B-Base | 8k | HuggingFace | ModelScope | WiseModel | OpenXLabl |

| ChatGLM3-6B-32K | 32k | HuggingFace | ModelScope | WiseModel | OpenXLab |

| ChatGLM3-6B-128K | 128k | HuggingFace | ModelScope| OpenXLab |

发表评论